Ein verzerrtes Bild der Wissenschaft

Montag, 18.03.2024

Die Serie „Scorpion“ hat mir vor kurzem Anlass gegeben, über die fragwürdige Darstellung des Themas Intelligenz zu schreiben. In derselben Serie wird auch ein seltsam gefärbtes Bild der Wissenschaft erzeugt. Das hat durchaus System.

Ein Team von Genies wird zu einem Einsatz gerufen, um Menschen zu retten, wenn nicht gar die ganze Menschheit. Dabei passieren in jeder Folge Komplikationen und Pannen, die das Team in höchste Gefahr bringen. In kürzester Zeit müssen sie mit oft primitiven Mitteln eine Lösung aus scheinbar ausweglosen Situationen finden. Das ist das Muster aller Folgen der Serie, die durchaus Unterhaltungswert hat.

In diesen Folgen wird ein bestimmtes Bild der „Wissenschaft“ gezeichnet, das mit der Realität wenig zu tun hat. Das ist schade, weil sich die Serie vor allem an jugendliche Zuschauer richtet, die dieses Wissenschaftsbild für bare Münze nehmen. Es werden auf diese Weise Konzepte gepflegt, die wir getrost als Misskonzepte bezeichnen können.

Das Misskonzept zu hoher Genauigkeit

In einer Folge befindet sich ein „Genie“ mit einer normalen Person in einer höchst gefährlichen Situation. Das Genie sagt dann: „In solchen Situationen hilft es mir, auszurechnen, wie hoch die Chancen sind, hier wieder heil herauszukommen“. Auf die Frage der normalen Person, wie hoch die Chance denn sei, ist die Antwort „48,6 Prozent“.

Eine solch genaue Berechnung von Wahrscheinlichkeiten ist natürlich kompletter Unsinn. Dieser Unsinn setzt sich jedoch in den Köpfen der jugendlichen Betrachter fest. Die entwickeln eine Art Gläubigkeit, die sich etwa so in Worte fassen lässt: „Ich selbst kann das nicht so genau berechnen, aber ein genialer Wissenschaftler kann das.“

In einer anderen Situation der Serie kommt das noch klarer zum Ausdruck, als ein Mitglied des Teams gefragt wird, ob er glaube, dass das Team aus einer Situation wieder heil herauskommt. Er antwortet: „Ich glaube an die Wissenschaft“. Dieser Satz tut im Kopf weh. Davon abgesehen ist er ein Widerspruch in sich selbst.

Was wäre denn eine angemessenere Darstellung der Möglichkeiten der Wissenschaft, wenn es um die Vorhersage des Ausgangs einer bestimmten Situation geht? Jede Situation hängt von einer Vielzahl von Voraussetzungen ab, von denen jede mit einer gewissen Unsicherheit behaftet ist. Diese Unsicherheiten vergrößern sich in der Kombination der Voraussetzungen. Liegt die Wahrscheinlichkeit, dass zwei bestimmte Voraussetzungen eintreffen, bei jeweils 50%, dann liegt die Wahrscheinlichkeit, dass ihre Kombination eintrifft, bei 25%. Je mehr Voraussetzungen erfüllt werden müssen, damit eine Situation ein bestimmtes gewünschtes Ende nimmt, umso mehr tendiert die Wahrscheinlichkeit, dass dieses Ende eintritt, gegen den Wert 0.

Wenn wir Werte kombinieren, die eine gewisse Unschärfe aufweisen, dann können wir Korridore angeben, in denen sich die einzelnen Werte bewegen. Die Kombination von zwei Werten ergibt dann eine Vergrößerung des kombinierten Korridors. Je mehr Werte kombiniert werden müssen, umso wahrscheinlicher ist es, dass der Korridor, in dem sich der kombinierte Wert – also das Resultat – befindet, vom Betrag her gleich oder größer ist, als der Wert, den man voraussagen will. Kurz gesagt: Man kann mit dem berechneten Wert nichts mehr anfangen.

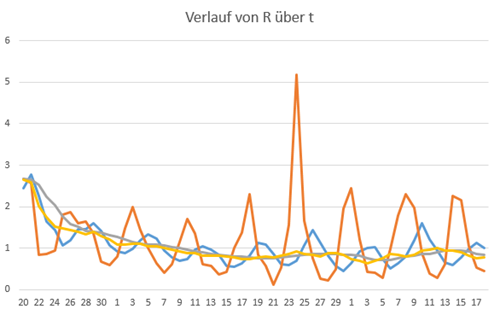

Ein gutes Beispiel für solch einen kombinierten Wert ist die Berechnung der Reproduktionsrate R während der Corona-Pandemie. Es wurden Inzidenz-Daten erfasst, die eine große Ungenauigkeit aufwiesen. Dazu kam noch ein wellenförmiger Verlauf der Daten, der aus dem ungleichmäßigen Meldeverlauf über die Woche hinweg stammte:

Die wellenförmigen Kurven sind die Berechnung des Werts R mit verschiedenen Verfahren, wobei die blaue Kurve das Verfahren des Robert-Koch-Instituts (RKI) darstellt. Die gelbe und graue Kurve sind zwei Verfahren zur Glättung der Kurve. Trotz der großen Unschärfe der zugrundeliegenden Daten beschloss das RKI, den berechneten Wert von R ab Mitte April 2020 mit zwei Stellen hinter dem Komma anzugeben. Das suggeriert eine Genauigkeit, die zu keinem Zeitpunkt gerechtfertigt war.

Das Misskonzept der Vorhersagbarkeit

Welchen Zweck kann eine solche übertriebene Genauigkeit als „wissenschaftliches“ Ideal verfolgen? Im Grunde dient sie der Übermittlung des mechanistischen Weltbilds, das sich am Besten durch die Figur des Laplaceschen Dämons ausdrücken lässt. Die Idee ist etwa folgende: Wenn es ein Wesen gäbe, das alle Naturgesetze kennt und in einer Situation alle Voraussetzungen wie Lage, Geschwindigkeit, Temperatur etc. kennt, könnte dieses Wesen den Verlauf der Situation vorhersagen.

Die Genies in der Serie werden als Personen dargestellt, die dem Laplaceschen Dämon ziemlich nahe kommen. Damit wird ein Weltbild vermittelt, das veraltet ist und mit der Realität nichts zu tun hat. Die Realität wird geprägt von Einflüssen, die eine große Unschärfe aufweisen, wie zum Beispiel psychologische oder biologische Einflüsse. Wir müssen also gar nicht die Unschärferelation bemühen, um zu zeigen, dass ein Laplacescher Dämon nicht existieren kann.

Zur Vorhersage von Situationen gehört die Einschätzung des Verhaltens der beteiligten Personen. Die Psychologie ermöglicht uns eine grobe Abschätzung, welche Einflüsse auf eine bestimmte Situation wirken könnten, aber das ist auch schon alles. Verhalten lässt sich nicht berechnen. Im Übrigen lassen sich auch biologische Vorgänge nicht so genau berechnen, wie Vorgänge in der Physik.

Aber selbst, wenn wir es mit konstruierten Systemen zu tun haben, deren Verlauf durch mathematische Gleichungen bestimmbar ist, gibt es Grenzen der Vorhersagbarkeit. Der folgende Abschnitt ist ein wenig komplizierter, kann aber auch übersprungen werden, ohne den Sinn dieses Blogbeitrags zu verpassen.

Grenzen der Vorhersagbarkeit durch Irreduzibilität

Der Wissenschaftler Stephen Wolfram, Erfinder des computergestützen Algebra-Systems Mathematica bringt einen weiteren Aspekt ein, der die Vorhersagbarkeit von Situationen einschränkt. Angenommen, eine Situation beruht völlig auf Voraussetzungen der Art, dass der weitere Verlauf exakt berechenbar ist. Anders gesagt: Die Situation ist ein System, dessen Funktion sich durch das Lösen von Gleichungssystemen vorhersagen lässt.

Wenn nun die Berechnung des Ausgangs der Situation länger dauert, als der reale Fortgang, hilft uns die Berechenbarkeit nicht viel. Wissenschaftliche Voraussage hängt davon ab, ob wir ein Modell der Funktion des Systems finden können, das der Situation zugrunde liegt.

Ein Modell ist eine Vereinfachung der Realität. Oder anders gesagt: Wenn wir die Lösung des Gleichungssystems vereinfachen und trotzdem ausreichend genaue Resultate bekommen können, ist eine Vorhersage bzw. Simulation des Verhaltens des Systems möglich (und nur dann). Das Problem der meisten wissenschaftlichen Fragestellungen ist die Irreduzibilität der Berechnungen, die für die Vorhersage nötig sind:

Ein Schlüsselgedanke […] besteht darin, dass wir uns alles, was geschieht, als einen Rechenprozess vorstellen können. Das System führt eine Berechnung durch, um sein Verhalten zu bestimmen. Wir Menschen […] müssen ebenfalls Berechnungen durchführen, um zu versuchen, dieses Verhalten vorherzusagen oder zu „lösen“.

Der Grundsatz der Gleichwertigkeit von Berechnungen besagt jedoch, dass diese Berechnungen in ihrer Ausgereiftheit höchstens gleichwertig sind. Das bedeutet, dass wir nicht erwarten können, das System systematisch „vorhersagen“ oder „lösen“ zu können; es erfordert unweigerlich einen gewissen, nicht reduzierbaren Rechenaufwand, um herauszufinden, was genau das System tun wird.

So sehr wir uns auch bemühen, ob mit KI oder auf andere Weise, unsere "wissenschaftliche Leistung" wird letztlich durch die rechnerische Irreduzibilität (unzerlegbare Darstellung) des Verhaltens begrenzt sein.

Das Misskonzept der Faktenbasiertheit

In der Serie äußern die „Genies“ in verschiedenen Situationen, dass für sie nur die Fakten zählen, die sie dann zu ihren Schlussfolgerungen verarbeiten. Da spätestens mit Donald Trump das postfaktische Zeitalter ausgerufen wurde, lohnt es sich, einen Moment innezuhalten für die Frage, was Fakten überhaupt sind.

Wir können getrost als Fakt annehmen, dass die Erdbeschleunigung auf unserem Planeten 9,81m/s2 beträgt. Das ist aber letztendlich nur eine Schlussfolgerung aus Fakten, die vorher ermittelt worden sind. Dazu werden Experimente unternommen. Zum Beispiel können wir Gegenstände aus verschiedenen Höhen auf die Erde fallen lassen und die Zeit messen, die die Gegenstände brauchen, um auf dem Boden aufzukommen.

Wenn wir das tun, werden wir sehen, dass wir ein paar Störfaktoren beseitigen müssen, die unsere Messungen beeinträchtigen, wie zum Beispiel den Einfluss der Luft auf das Fallen der Gegenstände. Wir stellen fest, dass ein Blatt Papier langsam zu Boden segelt, während eine kompakte Metallkugel die Strecke wesentlich schneller bewältigt. Lassen wir die gleichen Gegenstände jedoch in einem Vakuum zu Boden fallen, zeigt sich (für viele Menschen vielleicht überraschenderweise), dass das Blatt Papier und die Metallkugel gleich schnell zu Boden fallen.

Die gemessenen Zeiten für den Fall der Gegenstände sind die Fakten, mithilfe derer wir auf die Gesetzmäßigkeit schließen können, die dem Phänomen zugrunde liegt, nämlich die Erdbeschleunigung. Unsere Technologie ist heutzutage so fortgeschritten, dass wir diesen Versuch mit fast beliebiger Genauigkeit durchführen können.

Sind das noch Fakten, oder kann das weg?

Das verführt dazu, die Faktenbasiertheit der Wissenschaft als eine Art Glaubenssystem anzunehmen. So hat der allseits bekannte Chefvirologe der Charité Christian Drosten zu Beginn der Corona-Pandemie sinngemäß gesagt:

Die Wissenschaft liefert die Fakten als Entscheidungsgrundlage, aber die Entscheidung, welche Maßnahmen getroffen werden, liegt bei der Politik.

Betrachten wir näher, von welchen Fakten Herr Drosten da spricht, stellen wir fest, dass wir uns auf Meldungen verlassen mussten, die von Gesundheitsämtern ans RKI gemeldet worden sind. Die Meldungen betrafen Fälle von positiven Tests, die mit einem bestimmten Verfahren (PCR-Test) durchgeführt werden. Es gibt nun ein paar Ungenauigkeiten, die aus diesen Meldungen resultieren:

- Es musste eine hohe Dunkelziffer angenommen werden, die durch repräsentative Studien hätte abgeschätzt werden müssen. Diese Studien wurden jedoch nie vorgenommen.

- Die gewonnenen Inzidenzdaten wiesen eine große periodische Schwankung im Wochenrhythmus auf.

- Nur etwa die Hälfte der positiven Fälle zeigte Symptome.

- Die Zuordnung der Meldung zu einem bestimmten Zeitpunkt war für knapp die Hälfte der Datenpunkte nicht zu leisten.

- Die zeitliche Zuordnung der Fälle ohne Symptome wurde mit Imputation bestimmt.

- Auf diesen mit dem so genannten „Nowcast“ aufbereiteten Daten wurde nun der Forecast vorgenommen.

Es ist klar, dass die Meldeinfrastruktur der Gesundheitsämter wesentlich verbessert werden muss, wenn man künftigen Epidemien sinnvoll begegnen will. Aber darauf will ich nicht hinaus.

Ich will darauf hinaus, dass die Daten, die eine ziemlich große Unschärfe aufwiesen, zur Berechnung einer Kennzahl R verwendet wurden, die dann – in eine Exponentialfunktion eingesetzt – für einen Forecast des Infektionsverlaufs verwendet wurden. Das Verfahren habe ich in diesem Artikel beschrieben. Die zweite Kennzahl der Exponentialfunktion, nämlich T, kann beim vom RKI verwendeten Verfahren nur als Ganzzahl eingesetzt werden, die mehr oder weniger aus dem Bauch heraus auf 4 Tage festgelegt wurde.

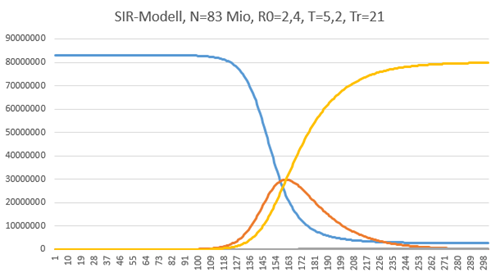

Das Modell, das der Exponentialfunktion zugrunde liegt, ist ein ziemlich simples mathematisches Modell (SIR-Modell), das ich hier beschrieben habe.

SIR-Modell. Die braune Kurve zeigt einen Forecast des Infektionsgeschehens über die Zeit in Tagen.

Das Modell lässt einige Einflussfaktoren unberücksichtigt, die eine Verflachung der Modellkurve bewirkt hätten1. Auf Basis der Meldezahlen, die in das simple Modell eingesetzt wurden, berechnete man den Forecast, der der Politik als Fakt übermittelt wurde, mit der Schlussfolgerung, dass wir uns mitten in einer Katastrophe befinden. Die Folgen sind uns allen bekannt. Dass auch ich diese Vereinfachung mit der Realität verwechselt habe, habe ich in diesem Beitrag dargestellt. Kurz zusammengefasst:

- Die Zahlen waren zu unscharf2

- Das Modell war zu simpel

Diese Forecasts haben mit „Fakten“ im Wortsinn nichts zu tun. Aber es wurde suggeriert, als ob „die Wissenschaft“ auf Fakten basiert. Das war aber nicht der Fall und das wurde nicht kommuniziert. Man konnte sich auf die Wissenschaftsgläubigkeit in der Bevölkerung verlassen, die das Gegenteil einer kritischen Betrachtung der angewandten Methodik ist. Daran sieht man, dass der „Glaube an die Wissenschaft“ keine gute Idee ist.

Eine gute Idee wäre eine Verbesserung der Faktenlage und eine Verfeinerung der Modelle gewesen. Vier Jahre nach Beginn der Pandemie kann ich nicht erkennen, dass sich in dem Bereich etwas zum Besseren verändert hätte. Um das klar zu betonen: Ich habe nichts gegen Fakten. Ich habe etwas gegen den Habitus, dass simplifizierte Modellberechnungen auf Basis von schwammigen Zahlen als Fakten verkauft werden.

Das Misskonzept der Evidenz

Ein weit verbreitetes Misskonzept, das an Schulen und Unis gelehrt wird, ist, dass Wissenschaft evidenzbasiert sein muss. Ich habe mir ein paar Diskussionen über Wissenschaft (zum Beispiel auf heise.de) angeschaut und finde dabei immer wieder die Behauptung, dass nur evidenzbasierte Methoden wirklich Wissenschaft sind.

Wenn dem so wäre, müssten wir die Relativitätstheorie als unwissenschaftlich bezeichnen. Soweit ich weiß, ist der Nachweis der Gravitationswellen erst vor wenigen Jahren gelungen. Erst seitdem dürfte man die Relativitätstheorie als wissenschaftlich bezeichnen und vorher war sie es nicht – sorry, Albert…

Diese Sichtweise ist natürlich kompletter Unfug.

Nehmen wir einmal Wissenschaften als Beispiel, die mit Phänomenen hantieren, die mit einer gewissen Unschärfe behaftet sind, wie die Medizin und die Psychologie. In diesen Wissenschaften ist es Usus, Studien vorzunehmen, deren Ergebnisse dann und nur dann als gesichert gelten, wenn eine bestimmte statistische Kenngröße erreicht wird. Ist das der Fall, spricht man von Evidenz.

Als ich vor ein paar Monaten mit seltsamen Phänomenen der Schwäche in der Arztpraxis auftauchte und dort mit einem EKG Kammerflimmern festgestellt wurde, sagte die Ärztin zu mir: „Das ist in Ihrem Alter normal“. Eine solche Aussage ist in meinen Augen unwissenschaftlich. Die Ärztin mag ihre Nase tief in die Studien gesteckt haben, die diesen Schluss nahelegen. Aber sie hat vollständig das Faktum ignoriert, dass die Schwäche quasi von null auf gleich über mich kam.

Darüber könnte ich einen eigenen Beitrag schreiben, der sich mit dem Gegensatz von Evidenz und Empirie beschäftigt, der dann auftritt, wenn die statistische Wahrscheinlichkeit mit der Realität verwechselt wird. In anderen Worten: Die schönste Evidenz der Studien erspart es den Ärzten nicht, den konkreten Patienten eingehend zu untersuchen.

Gottseidank gab es andere Ärzte, Kardiologen, die mit ausgefeilter Diagnostik feststellen konnten, dass meine Gefäße in einem überdurchschnittlich guten Zustand sind. Die Behandlung, die daraus folgte, war minimal invasiv und führte zur vollständigen Aufhebung der Schwäche. Ich muss nicht für den Rest meines Lebens Betablocker und Blutverdünner nehmen und damit gehöre ich zu den unwahrscheinlichen Fällen meiner Altersgruppe. Ich bin froh, dass das festgestellt werden konnte, denn das hebt meine Lebensqualität deutlich.

Im Bereich der Psychologie geht der Glaube an die Evidenz noch weiter. So schön die Ergebnisse der Verhaltensforschung sind, sie kann bestimmte Bereiche der menschlichen Psyche nicht erfassen. Um diese Bereiche der Psyche zu erforschen, ist der Aufbau einer persönlichen Beziehung zwischen Therapeuten und Patienten nötig. Für die Wissenschaft ist das ein Problem: Der subjektive Faktor spielt auf einmal eine Rolle. Die Therapeuten müssen eine entsprechende Persönlichkeitsbildung durchlaufen haben, damit sie eine solche Beziehung überhaupt aufbauen können. Nur dann winkt die Erkenntnis.

Forschung in diesem Bereich ist ohne Berücksichtigung des subjektiven Faktors nicht möglich. Die Psychoanalyse trägt diesem Phänomen durch den Begriff der Gegenübertragung Rechnung. Aber auch die klientenzentrierte Psychotherapie nach Carl Rogers fordert für eine erfolgreiche Psychotherapie den Aufbau einer Beziehung zu den Klienten. Es ist beeindruckend, mit welcher Akribie Rogers hunderte von Gesprächsprotokollen analysierte um letztendlich die Faktoren zu identifizieren, die eine Gesprächspsychotherapie effektiv machen. Wer sich einen Eindruck davon verschaffen will, dem sei das Buch „Die klientenzentrierte Gesprächspsychotherapie“ empfohlen.

Diese Methoden werden aber von Verfechtern der evidenzbasierten Verhaltensforschung als „unwissenschaftlich“ vom Tisch gewischt.

Warum aber wird die Bedeutung der Evidenz so überhöht, dass sie fast synonym mit dem Begriff Wissenschaft eingesetzt wird? Ich vermute, dass dahinter die Scheu der Wissenschaftler vor der Auseinandersetzung mit ihrer eigenen Persönlichkeit steht. Der Psychoanalytiker und Begründer der körperorientierten Psychotherapie, Wilhelm Reich, beschrieb den Zusammenhang zwischen neurotischen Charakterstrukturen und der Art und Weise, wie geforscht wird. Das ist natürlich ein heikles Thema:

Kann ein Nerd eine sinnvolle Arbeit zum Thema Sexualität und Lebensfreude abliefern?

Darüber könnt Ihr Euch gerne eine eigene Meinung bilden.

Wissenschaft und Autorität

Wissenschaftler verfassen Studien. Zur Überprüfung der Methodik durchlaufen die Studien ein Peer-Review. Wenn die Reviewer grünes Licht geben, kann die Studie in einschlägigen Fachjournalen veröffentlicht werden.

Das klingt ziemlich seriös. Aber es gibt ein Problem mit den Veröffentlichungen. Der Ruf von WissenschaftlerInnen beruht auf zwei Faktoren:

- Wieviel er / sie bislang veröffentlicht hat

- Wie viele Zitate aus diesen Veröffentlichungen in anderen Publikationen auftauchen (h-Index)

Die folgende Geschichte mag die Wichtigkeit von Publikationen illustrieren: Während der Pandemie äußerte der Virologe Alexander Kekulé Kritik an einer Studie des Herrn Drosten. Herr Drosten reagierte ziemlich dünnhäutig:

Kekulé selbst könnte man nicht kritisieren, dazu müsste er erst mal etwas publizieren

Der Herr Kekulé wurde im Übrigen später von seiner Tätigkeit an der Uni Halle entfernt3.

Veröffentlichungen spielen also eine große Rolle. Wie aber kommt ein Wissenschaftler zu einer Veröffentlichung? Zunächst einmal braucht es Mittel, um die Kosten zu decken. Eine große Rolle bei der Vergabe öffentlicher Förderungen spielen die Akademien der Wissenschaften4. In unserem föderalen System leistet sich jedes Bundesland eine Akademie. Und es gibt einen Dachverband der deutschen Akademien, der wohl erst mit der Corona-Pandemie ins Bewusstsein der Bevölkerung gerückt ist: Die Leopoldina.

Darüber hinaus benötigt der / die WissenschaftlerIn einen Peer Reviewer, der das Vertrauen der Fachzeitschrift genießt. Ich möchte Euch nicht den Abend verderben, aber in bestimmten Wissenschaftsbereichen sitzen in den Akademien und den wissenschaftlichen Beiräten der wichtigsten Publikationen dieselben Leute.

Wenn Ihr also glaubt, Ihr könntet mit einer wissenschaftlichen Arbeit über den subjektiven Faktor in der Forschung eine Publikation ergattern, dann habt Ihr Euch getäuscht. Ihr werdet die Mittel nicht erhalten und leider Gottes wird sich auch kein Peer-Reviewer finden.

Für Eure wissenschaftliche Karriere wäre es also besser, wenn Ihr Euch ein anderes Thema sucht. Auf diese Weise wird subtil der Gegenstand von Forschung gesteuert. Und natürlich kann es nicht schaden, sich im Wissenschaftsbetrieb gut zu vernetzen. Sucht Euch Autoritäten in Eurem Forschungsbereich und macht Euch bei denen beliebt. Dann wird sich auch ein Peer-Reviewer finden.

Betrug in der Wissenschaft

Aber ist das nicht eine Einladung für allerlei Missbrauch? Könnten sich da nicht Freundeskreise gegenseitig in der wissenschaftlichen Bewertung nach oben hieven? Das ist undenkbar, oder? Dann müsste es doch jede Menge Studien geben, deren Ergebnisse Unsinn sind? Dieser Meinung ist zumindest der Forscher John Ionannidis, der ein Paper mit dem markanten Titel Why most Published Research Findings are False veröffentlicht hat.

Die Replikationskrise in der Psychologie und Medizin zeigt, dass unsaubere Arbeiten die Peer-Reviews überstehen konnten und dadurch zu Standardwerken in den jeweiligen Disziplinen werden konnten.

Aber es geht noch weiter. Es wurde ein ganzer Zirkel an Forschern zum Thema Krebs in Deutschland aufgedeckt. Es handelt sich vor allem um Frauen in hochdekorierten Positionen, die ihre Karrieren interessanterweise demselben Mentor verdanken. Ein Forscher konnte zeigen, dass angebliche Aufnahmen von Proben unter dem Mikroskop per Photoshop mit leichter Bearbeitung von einer Studie in die nächste übertragen wurden5. Personelle Konsequenzen werden wohl unvermeidbar sein.

Die Wissenschaftler, die solche Machenschaften aufdecken oder sich an die Replikation von Studien wagen, um nachzuweisen, dass sie nicht wiederholbar sind, können sich übrigens ebenso mit dem Ende ihrer Karriere befassen. Wer stellt schon einen Nestbeschmutzer ein?

Das Problem der Wissenschaft

Das Problem mit der Wissenschaft ist

- Die gezüchtete Autoritätshörigkeit im Wissenschaftsbetrieb

- Die klar hierarchische Ordnung

- Die Spezlwirtschaft in wissenschaftlichen Gremien und Akademien

Darüber hinaus werden schon den Kindern im Kindergarten und der Schule falsche Konzepte über die Wissenschaft beigebracht. Ich habe diese falschen Konzepte Misskonzepte genannt, in Anlehnung an einen Begriff, der mittlerweile als veraltet gilt und durch den Begriff „Präkonzepte“ ersetzt wurde. In dieser Arbeit über Misskonzepte umreißt der Autor anhand von Zitaten den Begriff folgendermaßen:

… Misskonzepte bei Kindern mit ihrer kindlichen Denkfähigkeit, die beschränkter sei, als bei Erwachsenen. Laut Shepard besitzen vor allem Jugendliche im Gegensatz zu Vorschulkindern und Erwachsenen mehr Misskonzepte. Darum spricht er von einem U-Trend.

Man könnte es auch so sehen: Die Kinder werden mit einer intuitiven Fähigkeit, die Natur zu verstehen, geboren. Infolge der Erziehung verlieren sie diese intuitive Fähigkeit, ihre Neugierde und ihre kritische Betrachtung der Welt um sie herum und nur ein winziger Prozentsatz der Menschen rettet diese Eigenschaften ins Erwachsenenleben.

Ein Großteil der Kinder übernimmt die angeblich so viel korrekteren Konzepte der Wissenschaft, die an den Schulen gelehrt werden, sie übernehmen den Glauben an die Wissenschaft und den Glauben an Autoritäten, die angeblich fähig sind, aus Fakten Voraussagen zu berechnen, und sie übernehmen den Glauben an das mechanistische Weltbild, das in der Gestalt des Laplaceschen Dämons gipfelt.

Die kindlich naiven Vorstellungen mag man gerne Präkonzepte nennen, aber für das, was den Kindern als angebliche Wissenschaft präsentiert wird, passt der Begriff Misskonzepte besser. Damit können wir die beiden Phänomene auch gut auseinander halten.

Die Wissenschaft der Nerds

Unsere Gesellschaft züchtet mit solchen Bildern Nerds, wie sie in der Serie Scorpion so schön dargestellt werden. Aber, wie ich in meinem Beitrag über Intelligenz schon bemerkt habe, sind meiner Erfahrung nach wirklich intelligente Menschen kontaktfreudig, spritzig, witzig, geistreich und vielseitig in ihren Interessen.

Karriere in der Wissenschaft machen aber diejenigen, die verstehen, wie die Macht in wissenschaftlichen Zirkeln verteilt wird und wie sie sich entsprechend vernetzen müssen.

Eine Wissenschaftlerin stellt sich die Frage, warum in der Physik in den letzten Jahrzehnten nicht so recht etwas weiter gegangen ist. Sie hebt dann darauf ab, dass es eine implizite Forderung gibt, dass Physik „schön“ sein muss und dass diese Forderung den Fortgang der Forschung behindert. Mein Eindruck ist eher, dass die falschen Typen in der Forschung sitzen. Und das liegt an den Machtstrukturen in der Wissenschaft und an der Ersetzung der kindlichen Neugier durch mechanistische Misskonzepte. Und ja: „schöne“ Theorien lassen sich besser publizieren.

_________

Update 21.03. Es gibt Kritik an meinem Beispiel der Auseinandersetzung Drosten vs. Kekulé. Erstens: Die Studie sei eine Preprint-Studie gewesen und sei veröffentlicht worden, um eben den finalen Text mithilfe konstruktiver Kritik zu erarbeiten. Zweitens stört man sich an der „kritiklosen Übernahme“ des Begriffs dünnhäutig aus der Springer-Presse.

Ich gehe in meinem Beispiel nicht auf den fachlichen Gegenstand der Diskussion ein. Ich will nur zeigen, dass Publikationen für Wissenschaftler so eminent wichtig sind, dass dadurch eine Kritik ad-hominem möglich ist. Und genau das ist in dem Beispiel der Fall.

Ob eine Äußerung dünnhäutig ist oder nicht, ist natürlich der persönlichen Einschätzung überlassen. Daher hier nochmal der gesamte Text von Drostens Äußerung auf X (ex-Twitter):

Kekulé macht Stimmung. Seine Darstellung ist tendenziös. Er kennt unsere Daten nicht und zitiert falsch. Kekulé selbst könnte man nicht kritisieren, dazu müsste er erstmal etwas publizieren.

Zum Thema Preprint: Ich verstehe das nicht so, dass Preprints eine Art „Vorstudie“ sind. Preprints werden auf speziell dafür geschaffenen Plattformen veröffentlicht, wenn Wissenschaftler der Auffassung sind, dass der Gegenstand bzw. das Ergebnis ihrer Forschung so wichtig ist, dass man nicht den üblichen Review-Prozess abwarten will, der normalerweise bei einer Veröffentlichung von Studien durchlaufen wird. Außerdem geht es hier um den Termin der Erstveröffentlichung bei wichtigen Entdeckungen, der dadurch nach vorne rücken kann. Ich zitiere aus der Wikipedia:

Durch die Veröffentlichung von Preprints wird die Geschwindigkeit erhöht, mit der Forschungsergebnisse in der wissenschaftlichen Welt verbreitet werden. Einerseits ermöglicht dies kritisches Feedback von anderen Forschungsgruppen zur geleisteten Arbeit, ehe diese den formalen Begutachtungsprozess des Verlags durchläuft. Zum anderen kann die Wissenschaftsgemeinschaft auf den veröffentlichten Daten im Idealfall aufbauen und dadurch die eigene Forschungsarbeit schneller vorantreiben.

Damit wird der Preprint zwar auch eine Einladung zur Kritik, aber es geht mindestens genauso sehr darum, die Denkrichtung weiterer Forschung zu beeinflussen – in dem konkreten Fall, dass man annehmen muss, dass bezüglich SARS Cov 2 Kinder genauso ansteckend wie Erwachsene sind.

_________

1 Ihr erinnert Euch? „Flatten the Curve“? Die Berücksichtigung von dämpfenden Faktoren in den Modellen, wie zum Beispiel die Überschreitung von Clustergrenzen bei der Ausbreitung, hätte in den Forecasts automatisch zu einer flacheren Kurve geführt.

2 Was die Zahlen anbetrifft, könnte man zurecht argumentieren: Wir hatten halt keine besseren Zahlen. Aber dann wäre ein Hinweis auf die große Unschärfe der Berechnungen angebracht gewesen.

Was das zu simple Modell anbetrifft: Die Ausbreitung von Epidemien folgt nur in gröbster Annäherung den im SIR-Modell angegeben mathematischen Gleichungen. Die Tendenz geht im SIR-Modell in Richtung zu hoher Ausbreitung. Es beschreibt den zugrundeliegenden Mechanismus der Ausbreitung. Es gibt aber dämpfende Faktoren, deren Ermittlung leider extrem schwer ist. Dazu müssten in der Bevölkerung Zahlen erhoben werden, die sehr schwer zu ermitteln sind und die eine große Unschärfe aufweisen.

Angenommen, man hätte die mittlere Clustergröße für Freundeskreise in Deutschland ermittelt. Das Ergebnis ist keine Zahl, sondern ein Korridor. Setzt man nun diesen Korridor in die Gleichung ein, erhält man einen Ergebniskorridor, der als Vorhersage ungeeignet ist.

Daher lässt man diese dämpfenden Faktoren in den Forcasts weg, zum Teil mit der Begründung, dass sie ohnehin in die Reproduktionsrate R0 eingehen. Hier zeigt sich aber ein Beispiel von Irreduzibilität. Man kann diese Faktoren nicht weglassen, ohne die Qualität der Vorhersage extrem zu mindern.

Das ist das Problem: Man hat auf beiden Wegen eine schlechte Vorhersage.

3 Der Vorwurf gegen Kekulé ist, dass er zu wenig Lehrangebote gemacht hat. Eine kurze Beschreibung der Vorgänge findet sich hier. Ich habe zu dem Thema keine Meinung. Ich weiß zu wenig darüber.

4 Eine weitere Finanzierungsquelle sind Mittel aus der Wirtschaft. Um solche Mittel zu ergattern, muss die Forschung verwertbare Ergebnisse zum Ziel haben.

Well, what do you say to that. Two of Germany’s most influential scientists were caught with bad science. Our heroes are Klaus-Michael Debatin and his former mentee Simone Fulda.

Fulda is currently President of the University of Kiel, prior to that she was Vice-President for Research at the Goethe University of Frankfurt. Debatin used to be Dean of the Medical Faculty and Vice-President for Medicine of the University of Ulm, as well as CEO and Medical Director of the university clinic. He and Fulda sit on the boards of the most important academic institutions and charities in Germany and abroad. Both are Fellows of the German Academy of Sciences, Leopoldina (CVs here and here).

Both are Senators of the German Research Council (DFG). Both hold senior positions at the German Cancer Aid (Deutsche Krebshilfe) charity. Fulda also advises the Paul Ehrlich Institute, decides about the fellowships at Alexander von Humboldt Foundation, coordinates regional research investments of the Mercator Research Center Ruhr and the German-Israeli research cooperation of the DFG. She also used to be member of the German Science and Humanities Council (Wissenschaftsrat) and currently chairs the Research Information Committee at the Joint Science Conference, which advices the national and federal state governments.

In a way, a biomedical scientist can’t even fart in Germany without permission from Fulda and Debatin.

Kommentare

Kein Kommentar zu diesem Beitrag

Weitere Artikel

- Das personifizierte Böse

- Bei uns gibt es keine Kriegspropaganda

- Tagesgeschehen am 13.05.25

- Tagesgeschehen am 10.05.25

- Tagesgeschehen am 09.05.25

- Tagesnachrichten 6-8. Mai

- Tagesnachrichten

- Was tun wir, wenn wir diskutieren?

- Herr Höttges und die gierigen Bastarde

- With Great Power Came No Responsibility