Die Diskussion um die Gefahren der KI

Sonntag, 07.05.2023

Mit Geoffrey Hinton hat sich ein Wissenschaftler zum Thema KI geäußert, der ein klein wenig Berufung mitbringt. Er ist nämlich einer der Entwickler der neuronalen Netzwerke, die in den modernen Sprachmodellen wie GPT-4 eingesetzt werden. Und er kommt mit einer Warnung daher, die aufhorchen lässt.

Bevor ich auf Hintons Warnung und deren Verarbeitung bei Heise zu sprechen komme, möchte ich kurz mal diejenigen Leute abholen, die sich bislang nicht so recht vorstellen konnten, was KI ist. Die KI basiert auf dem Wissen über die Funktionsweise der Neuronen im menschlichen Gehirn. Diese werden in „Neuronalen Netzwerken“ in einem Computer simuliert. Die Simulation spiegelt dabei nicht detailliert die Funktionsweise des menschliche Gehirns, sondern sie ist ein extrem vereinfachtes Modell.

Künstliche Intelligenz im Schnelldurchlauf

Die simpelste Implementierung dieser Idee ist, dass wir ein Netz von Leitungen spannen. Das könnt Ihr Euch vorstellen, wie die Linien auf einem Karopapier. Von links kommen die Informationen, die eingespeist werden (Eigenschaftsleitungen). Von oben kommen Informationen über die Bedeutung der Eingaben (Bedeutungsleitungen). An jedem Knotenpunkt ist eine Speicherzelle. Eine solche Zelle speichert aber nicht Bits (die ausschließlich die Werte 1 und 0 annehmen können), sondern Zahlenwerte. Wir legen links und oben eine Information an, und auf einen Impuls hin wird die Information mit der bereits vorliegenden Information in den Zellen verknüpft und der neue Wert abgespeichert. Dabei ist es so, dass Informationen von Zelle zu Zelle weitergegeben werden, wobei sie durch eine Übertragungsfunktion transformiert werden.

Die simpelste Art der Verknüpfung wäre eine Art Durchschnittswert aus der Eingangsinformation, der Bedeutungsinformation und der gespeicherten Information. Die heutigen Verfahren sind da natürlich wesentlich ausgereifter.

Nun kann man auf den horizontalen Leitungen eine Abfrageinformation anlegen. Auf einen Impuls hin wird nun auf den vertikalen Leitungen die Bedeutung ausgegeben. Das Resultat ist also nicht exakt, sondern wird aus der Ursuppe der eingegebenen Informationen extrahiert.

Aus der Sicht von KI-Spezialisten weist diese Erklärung ein paar große Löcher auf. Aber darüber können wir in diesem Beitrag großzügig hinwegsehen. Es geht ums Prinzip. Ich habe einen Algorithmus beschrieben, der Eingabeinformationen in Zellen speichert und aus einer Art Durchschnittswert aller Eingabeinformationen ein Ergebnis produzieren kann.

Worauf ich mit dieser Erklärung hinaus will, ist das Folgende: Das Ergebnis einer Abfrage an solch ein System ist nicht abhängig von Algorithmus, mit dem das System betrieben wird. Das Ergebnis hängt ausschließlich von den Eingabeinformationen ab. Diese Daten werden auch „Trainingsdaten“ genannt. Große KI-Modelle brauchen Unmengen an Trainingsdaten, um halbwegs brauchbare Ausgabeinformationen zu produzieren und verbrauchen dafür so viel Strom wie eine Stadt mit ein paar Tausend Einwohnern.

Was eine KI als Ergebnis einer Abfrage ausspuckt, ist nicht erklärbar. Wenn Ihr ein und dieselbe Abfrage öfters absetzt, werdet Ihr feststellen, dass die KI auch immer eine unterschiedliche Antwort gibt.

Wir wollen den Algorithmus!

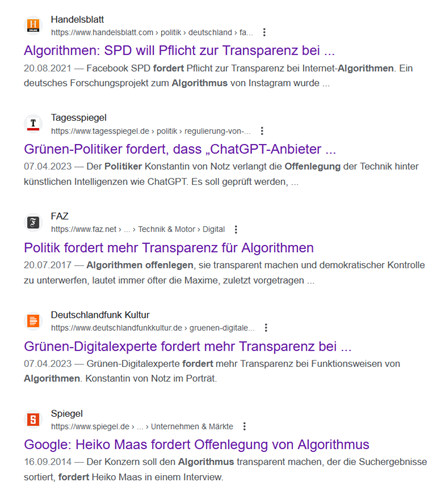

Vor diesem Hintergrund erscheinen Forderungen, dass große Internet-Anbieter ihre Algorithmen offenlegen sollen, ziemlich unsinnig. Eine Suche danach offenbart jedoch, dass sich diese Erkenntnis noch nicht bis in die Politik herumgesprochen hat. Und das wiederum lässt etwas an den Experten zweifeln, die die Politiker beraten:

Ich greife hier einmal stellvertretend ein Zitat des „Digitalexperten“ der Grünen heraus:

Bei KI-Anbietern muss die Geheimformel geprüft werden können, um sicherzustellen, dass ein rechtlich und ethisch vertretbares Produkt angeboten wird. Für die Zukunft ist eine Zertifizierung von KI denkbar, eine Art Prüfsiegel. Unabhängige Aufsichtsbehörden, auch und gerade auf EU-Ebene, werden sehr genau hinschauen müssen.

Das ist – leider muss ich das so sagen – Unsinn.

Der Algorithmus beschreibt nur, wie trainiert und wie abgefragt wird. Er hat keinen Einfluss darauf, was ausgegeben wird.

Nebst dem, dass die KI-Modelle permanent mit neuen Daten gefüttert werden, da ja täglich Unmengen neuer Daten im Internet entstehen, können KI-Modelle auch an ihren eigenen Ergebnissen trainiert werden. Das könnt Ihr mit einem Account zum Herumspielen mit ChatGPT selbst herausfinden. Ihr stellt eine Frage. Und wenn Ihr mit der Antwort nicht zufrieden seid, dann präzisiert Ihr die Frage. Dadurch erhält das Modell einen Eindruck davon, was seine erste Antwort wert war und wird dadurch verfeinert.

KI-Modelle sind also Moving Targets: In jeder Sekunde verändert sich ihre Gesamtstruktur und damit die Ergebnisse, die sie produzieren. Nehmen wir einmal die KI, die die Suchergebnisse von Google berechnet. Angenommen, jemand wirft Google vor, die Suchergebnisse in gewisse Richtungen zu manipulieren. Da kann Google dann sagen: Das ist kein Algorithmus, das hat unsere KI so ausgegeben. Das führt zu einer ersten Erkenntnis:

KIs sind sind ein probates Mittel, wenn es darum geht, die Verantwortung für das Verhalten von Systemen abzuschieben.

Vielleicht erleben wir einmal eine Zeit, in der KIs als juristische Personen agieren.

Google wird seine Algorithmen nicht herausgeben, weil sie als Geschäftsgeheimnis geschützt sind. Aber selbst wenn diese Algorithmen herausgegeben würden, könnte man daran keine Manipulation erkennen. Die Manipulation findet statt, aber in der Phase, in der das Modell trainiert wird.

Zurück zum Moving Target. Durch spezielle mathematische Verfahren können Modelle auch immer selbst eine Bewertung ihres Outputs vornehmen, indem ein Erwartungswert mit dem tatsächlichen Ausgabewert verglichen wird. Sie können also selbständig (ohne äußeres, menschliches Zutun) lernen. Und an dem Verfahren, mit dem das möglich ist (Backpropagation), hat Geoffrey Hinton gearbeitet. Geoffrey Hinton war zuletzt bei Google beschäftigt, ist dort aber vor kurzem ausgeschieden, damit er ohne Rücksicht auf die Firmenbelange seine Erkenntnisse über die KI äußern kann. Zitat:

Ich möchte über KI-Sicherheitsfragen sprechen, ohne mir Gedanken darüber machen zu müssen, wie sich dies auf das Geschäft von Google auswirkt

Das Zitat stammt aus einem Artikel von Heise, in dem ein Interview wiedergegeben wird, das er kurz vor seinem Ausscheiden gegeben hat. Auf diesen Heise-Artikel werde ich mich im Folgenden beziehen.

Geoffrey Hintons Kritik

Er sagt, die Entwicklung von GPT-4 „habe ihm klar gemacht, dass Maschinen auf dem Weg sind, viel schlauer zu werden, als er dachte […] Es beunruhigt ihn, wie sich das entwickeln könnte“.

Hier möchte ich kurz einhaken mit der Bemerkung, dass er unter „schlau“ nicht dasselbe versteht, was wir im Volksmund darunter verstehen. Eine KI ist per se nicht schlau, weil sie die Bedeutung der Informationen, mit denen sie hantiert, nicht erfassen kann. Wenn man denn so will, ist sie in der Lage, Muster zu erkennen, was unstrittig eine der Kerneigenschaften der Intelligenz ist.

Aber dieses Erkennen von Mustern, wie es im Lauf der Evolution wahrscheinlich alle Tiere entwickeln, wenn sie überleben wollen, hat keine nachgelagerte Stufe der Einordnung, wie es bei den Menschen mit dem Großhirn möglich ist. Es funktioniert eher wie eine Art neuronaler Reflex. Wenn ein Fußballer zwei Meter vor Manuel Neuer abzieht, dann ist es nicht ratsam für Manuel Neuer, über die Flugbahn des Balles nachzudenken. Er hält den Schuss nur deshalb, weil er seine Reflexe so trainiert hat, dass er ohne weitere Gehirnleistung eine passende muskuläre Aktion auslösen kann.

Das ist in etwa das Niveau der Intelligenz von KIs. Mit einem Unterschied: Manuel Neuer kann nach dem Schuss über die Situation reflektieren. Bei der KI bleibt es beim Reflex. Das ist also ein hochspezialisiertes System, das sehr schnell reagiert und dabei auf sehr viele Informationen zurückgreift. Dafür benötigt das System wesentlich weniger Neuronen wie das menschliche Gehirn, braucht aber wesentlich mehr Energie. Zitat Hinton:

Unsere Gehirne haben 100 Billionen Verbindungen. […] Große Sprachmodelle haben bis zu einer halben Billion, höchstens eine Billion. Doch GPT-4 weiß Hunderte Male mehr als jeder Mensch. Vielleicht hat es also tatsächlich einen viel besseren Lernalgorithmus1 als wir.

Geoffrey Hinton sagt uns hier, dass diese Modelle und die Algorithmen zum Trainieren und Lernen nicht einfach eine Nachbildung des menschlichen Gehirns sind, sondern etwas, was völlig anders funktioniert. Oder, um es mit seinen eigenen Worten zu sagen:

Diese Dinger sind völlig anders als wir. Manchmal denke ich, es ist, als wären Außerirdische gelandet und die Menschen hätten es nicht bemerkt, weil sie sehr gut Englisch sprechen.

Das wird ihm unheimlich, und deshalb ist ihm daran gelegen, dass die Menschen erst einmal nachdenken, bevor sie solche Systeme über einen gewissen Punkt hinaus entwickeln, an dem es für die Menschheit fatal werden könnte.

Seine Kritik geht nun in die Richtung, dass die KIs, wenn sie erst einmal selbständig lernen, ihren Einfluss so ausweiten könnten, dass sie einen Punkt ohne Wiederkehr auslösen könnten, dass also Dinge ins Kippen kommen, die nicht mehr beherrschbar sind.

Anpassen der Gesellschaft an die KI

Im gleichen Artikel wird ein anderer Wissenschaftler, nämlich Yoshua Bengio, zitiert, der eine noch interessantere Wendung formuliert:

Bengio stimmt mit Hinton darin überein, dass diese Probleme auf gesellschaftlicher Ebene so schnell wie möglich angegangen werden müssen. Aber er wirft auch ein, dass die Entwicklung der KI schneller voranschreitet, als Gesellschaften mithalten können. Die Fortschritte messen sich in Monaten, Gesetzgebung, Regulierung und internationale Verträge brauchen Jahre.

Daher fragt sich Bengio, ob die Art und Weise, wie unsere Gesellschaften derzeit organisiert sind – sowohl auf nationaler als auch auf globaler Ebene – der Herausforderung gewachsen ist. "Ich glaube, dass wir offen dafür sein sollten, ganz andere Modelle für die soziale Organisation unseres Planeten zu nutzen", sagt er.

Fordert hier tatsächlich jemand, dass sich die menschliche Gesellschaft der Evolution von Maschinen anpassen soll?

Wir kommen hier an einem Punkt, an dem der aufmerksame Leser vielleicht schon merkt, dass ein riesen Elefant im Raum steht und jeder tut so, als wäre er nicht da. Damit auch ja niemand auf den Elefanten zu sprechen kommt, schiebt Heise noch einen Artikel hinterher, der sich mit dem ideologischen Hintergrund beschäftigt, aus dem die Kritik Hintons an der KI hervorgeht.

Effektiver Altruismus

Wolfgang Stieler, der Autor des Artikels, stellt ein paar Paradigmen vor, die in bestimmten Kreisen begüterter Technologie-Anhänger kursieren. Als da wären: Effektiver Altruismus, Earning to give, Longtermism, existentielle Risiken (x-risk). Wer eine Kurzeinführung in diese Begriffe benötigt, der ist mit Stielers Artikel gut bedient.

Ich möchte kurz auf den Aspekt des Effektiven Altruismus eingehen. Ich zitiere aus dem Artikel:

Es gibt zu viel Elend, zu viele Probleme auf der Welt. Die können nicht alle gelöst werden. Wie kann das „knappe Gut“ möglicher Hilfe also möglichst „gewinnbringend“ eingesetzt werden.

Dies hängt zusammen mit einer weiteren Idee:

Weil jeder Mensch nur begrenzte Zeit und Energie aufwenden kann, ist es ethisch geboten, so schnell wie möglich so viel Geld wie möglich zu machen, um einen Teil dieses Geldes dann zu spenden.

Ich möchte darauf hinweisen, dass im Kontext des Artikels der Begriff Ideologie ausnahmsweise korrekt eingesetzt wird, weil es sich um Gedankengut einer Gruppe an Menschen mit einem klar definierten ökonomischen Hintergrund handelt. Das sind alles Leute, die auf die Segnungen der Technologie „zum Wohle der Menschheit“ setzen und damit bereits sehr viel Geld verdient haben. Sie betreiben eine Philosophie, über deren Grundlage Nietzsche sagen würde: „vermöge eines Vermögens“.

Es ist interessant, zu sehen, dass in solchen Kreisen kein einziger Gedanke daran verschwendet wird, wie es eigentlich zu Armut in der Welt kommt. Welche Strukturen machen Länder arm, welche geostrategischen Interessen führen zur Destabilisierung ganzer Regionen und erzeugen Flucht und menschliches Leid? Wenn man sich nicht dafür interessiert, sondern die Verhältnisse der betuchten Tech Bros in den USA mit den Verhältnissen in anderen Ländern vergleicht, kann einem leicht ein Satz über die Lippen kommen, wie seinerzeit dem Präsidenten George W. Bush:

Africa is a nation, that suffers from terrible desease.

Die Ignoranz, die diesem Satz zugrunde liegt, ist nahezu unerträglich.

Man denkt nicht darüber nach, worauf die Machtstrukturen auf diesem Planeten basieren und was das mit der Armut zu tun hat. Man denkt darüber nach, wie sich Technologie und Geld einsetzen lässt, um die Folgen der Armut zu lindern. Die Armut selbst wird akzeptiert wie eine Naturgewalt, die vom Himmel gefallen ist.

Dafür denkt man in diesen Kreisen über existentielle Risiken für das Überleben der Menschheit nach. Und man ist zu dem Schluss gekommen, dass die KI ein solches Risiko werden könnte (im Gegensatz zum Klimawandel, der vielleicht fatale Folgen habe, aber nicht zum Aussterben der Menscheit führen werde).

Daher folgert man daraus, dass man KIs nicht sich selbst überlassen darf, sondern durch deterministische Algorithmen einhegen muss, sodass die KI quasi in einer Box lebt. (Diese Algorithen könnte der Herr von Notz dann von Behörden bewerten lassen.)

Aber nun hat einer der bedeutenderen Tech-Bros-Philosophen in einem „Gedankenexperiment“ gezeigt, dass eine mächtige, selbstlernende KI die Fähigkeit haben werde, aus ihrer Box zu entkommen.

Das sind die Sorgen, die Geoffrey Hinton umtreiben.

Der Elefant im Raum

Ich hatte ja schon angedeutet, dass bei all diesen Diskussionen ein Elefant im Raum steht und niemand sagt: Hoppla Leute, hier steht ja ein Elefant. Kleiner Tipp am Rande: Wenn Ihr wissen wollt, ob ein Elefant im Kühlschrank war, dann achtet auf die Fußstapfen in der Butter.

Aber im Ernst: In den Kreisen, in denen Geoffrey Hinton verkehrt, hat noch nie jemand die Frage nach der Motivation gestellt, warum man überhaupt KI-Forschung betreibt. Der kritiklosen Akzeptanz dieser Forschung liegt ein Weltbild zugrunde, in dem die Wissenschaft und Forschung objektiv und neutral ist und Dinge hervorbringt, die der Menschheit nützen. Dieses Weltbild ist nach meinem Dafürhalten ein großes Missverständnis.

Ich erinnere mich noch sehr gut an den Werbespruch von Microsoft: „Information at your Fingertips". Der stammt aus einer frühen Zeit meiner beruflichen Laufbahn. Er erweckt den Eindruck, als ob die Forschung an technischen Innovationen nur deshalb geschieht, damit den Menschen das Leben leichter gemacht wird.

Ich denke, es gibt nur wenige Bereiche unserer Wirtschaft, in denen die technologische Entwicklung eine derartige Steigerung der Effizienz erzielt hat, wie in der Software-Entwicklung. Ich habe mich im Jahr 1986 selbständig gemacht und kann sagen, dass ich für dieselben Aufgaben, an denen ich damals gearbeitet habe, heute vielleicht ein Zehntel der Zeit benötigen würde. Ich bin also dank der besseren Technologie effektiver geworden. Welchen Nutzen hatte das für mich als Person?

Der Elefant, der im Raum steht, besteht darin, zu erkennen, dass ich heute, nach fast 40 Jahren, in denen ich unablässig in den Genuss technologischen Fortschritts gekommen bin, nicht etwa meine tägliche Arbeit in 0,8 Stunden erledigt habe, sondern nach wie vor meine 8-10 Stunden Arbeit pro Tag verrichte, um zu meinem Einkommen zu gelangen. Und so geht es allen anderen Personen in allen Branchen auf der Welt. Weniger Arbeit durch technischen Fortschritt? Fehlanzeige!

Und es geht weiter, mit immer demselben Argument:

Ich schreibe das nicht, um darüber klagen, aber ich stelle mir die Frage:

Wenn der ganze Fortschritt gar nicht für unseren Komfort gedacht war, wofür war er dann gedacht?

Ich werde an dieser Stelle keine fertige Antwort zu dem Thema hinterlassen. Denkt darüber nach und schreibt die Entwicklung in Gedankenexperimenten selbst fort. Wenn Ihr tatsächlich einen Impuls für die Auseinandersetzung mit dem Thema sucht, dann setzt Euch damit auseinander, warum unsere Gesellschaft eine permanent wachsende Wirtschaft und permanenten technologischen Fortschritt braucht. Spoiler: Das geschieht nicht für uns Menschen.

Derweilen werde ich nicht müde, mit den technischen Mitteln meiner Zeit meine Effizienz zu steigern, damit ich morgen nicht abgehängt bin. Und wenn es sein muss, unter Zuhilfenahme einer KI. Was bleibt mir schon übrig?

_____________

1 Das Wort Algorithmus kann hier zu Missverständnissen führen. Damit ist eben kein Algorithmus gemeint, der sich analysieren ließe, sondern die Gesamtheit der Vorgänge in einer KI, die im gegenwärtigen Zustand des Modells zu einer Antwort führt. Diese Gesamtheit ist per se nicht verstehbar. Hinton meint hier, dass KIs sehr effizient sind, was das Lernen von umfangreichen Informationen anbetrifft. Es geht hier ums Verhältnis zwischen der Anzahl der notwendigen Neuronen zum Umfang der Information, der theoretisch abrufbar ist.

Kommentare

Kein Kommentar zu diesem Beitrag

Weitere Artikel

- Als die Chinesen Tränen lachten...

- Der diskrete Charme der Bourgeoisie

- UNSER Wohlstand ist in Gefahr!

- Die Sozialausgaben steigen und steigen...

- Ein verzerrtes Bild der Wissenschaft

- Die weiße Fahne des Papstes

- Das nachträgliche Argument gegen Taurus

- Viele Menschen glauben – an die Propaganda

- Eine Geschichte über Intelligenz

- Die Demokratie - und ein Interview mit Putin